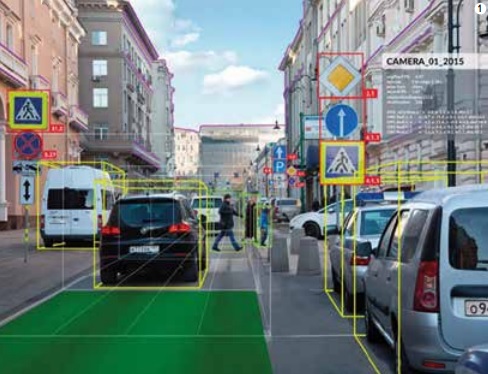

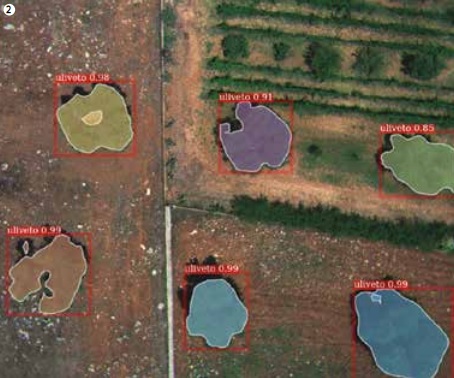

Dalle self-driving car che individuano gli oggetti al manufacturing per l’analisi dei difetti, dalla robotica come ausilio alla navigazione alla video sorveglianza e all’agricoltura di precisione. Scopriamo come, riproducendo le strutture elementari del cervello, la computer vision sta cambiando la nostra vita

La diffusione di smartphone con telecamere integrate di elevate qualità ha spinto le grandi multinazionali dell’Ict a investire nella generazione di servizi ad elevato valore aggiunto. Dietro le app che usiamo sui nostri cellulari si nascondono spesso algoritmi complessi di analisi delle immagini che emulano la cognizione visiva umana. Questi algoritmi di intelligenza artificiale sono in grado di riconoscere automaticamente gli oggetti presenti in una scena, come nel caso del riquadro che appare sui volti quando inquadriamo un’immagine, e vanno ben oltre perché sono progettati per emulare l’intelligenza umana nell’analisi di un video o di un’immagine.

Negli ultimi anni, gli studi di computer vision hanno compiuto dei formidabili passi avanti in tutti i settori della conoscenza. I metodi e i modelli che vi intervengono, noti con deep learning e reti neurali artificiali profonde, prendono spunto dal sistema biologico. La loro struttura si basa sulla struttura gerarchica e sulla peculiarità delle strutture elementari del cervello, scoperte da Hubel e Wiesel nel 1962. La struttura del cervello è caratterizzata da neuroni che elaborano le informazioni sensoriali in maniera massivamente parallela e con svariati livelli di complessità. Così, i formidabili risultati del deep learning sono stati ottenuti solo dopo che si è resa disponibile una sufficiente capacità di calcolo di alcune schede grafiche dei computer, in grado di elaborare in poco tempo e, oltretutto a basso costo, modelli neurali molto complessi.

I modelli (di reti) neurali vanno addestrati con degli esempi. Un metodo molto comune è il cosiddetto supervisionato, per il quale molte immagini vengono annotate e presentate alla rete neurale affinché impari a indicare il corretto nome di ciascun oggetto presente nell’immagine. C’è da dire che questi modelli sono molto complessi e necessitano di tante immagini. Più sono gli esempi che la rete neurale “osserva”, più precisa sarà la risoluzione di problemi di riconoscimento automatico. Le immagini necessarie per l’addestramento sono svariate migliaia e ognuna va annotata manualmente.

La generazione automatica della didascalia da una immagine (image captioning) è una delle applicazioni di visione artificiale che oggi vediamo sui social network. Questi algoritmi sono diventati sempre più performanti, non solo nel distinguere gli umani dagli animali e dagli oggetti inanimati, ma anche nell’individuare i singoli umani in base alle loro caratteristiche facciali. Proprio nel riconoscimento facciale, negli ultimi anni sono stati raggiunti miglioramenti importanti che hanno spinto i grandi produttori di elettronica di consumo a sviluppare chip per il processing neurale per lo sblocco di uno smartphone.

Sono sviluppi che tornano utili anche in un periodo come l’attuale dominato dall’emergenza coronavirus: sul mercato sono stati presentati tablet che sono in grado di integrare modelli di deep learning consentendo di distinguere se una persona indossa la mascherina e di riconoscerne il volto. Ancora nel contesto del Covid-19, il colosso Alibaba nei primi mesi del 2020 ha messo a punto modelli neurali per il riconoscimento automatico di pazienti affetti da Sars-CoV-2 a partire dalle slice della tomografia computerizzata, raggiungendo una precisione del 98% e usando meno di 10 secondi per la diagnosi. Queste metodologie, che sono a supporto del medico e forniscono un valore aggiunto, soprattutto se addestrate con immagini annotate da esperti in campo sanitario, permetteranno di migliorare la qualità della diagnosi. Prendiamo ad esempio il settore della dermatologia, in cui Isasi-Cnr sta sviluppando modelli neurali complessi da immagini prese da dermatoscopi portatili agganciati a smartphone. La diagnosi precoce di una lesione della pelle, ad esempio il melanoma, si basa nei suoi primi stadi sull’osservazione visiva, sull’esperienza del medico e quindi su quei meccanismi cognitivi visivi che conducono a individuare caratteristiche importanti della lesione per fornire una diagnosi. Un dermatologo deve osservare centinaia di immagini per imparare a riconoscere il melanoma, soprattutto nei primi stadi, laddove vi è una elevata probabilità di sopravvivenza. Il supporto dell’intelligenza artificiale avrà il beneficio di omogeneizzare le qualità delle diagnosi migliorandole, con il conseguente beneficio di fornire a tutti le stesse opportunità di qualità del consulto medico.

Uno studio su Nature del 2017 condotto dai ricercatori di Stanford ha evidenziato come il supporto fornito dall’intelligenza artificiale migliori l’accuratezza della diagnosi. Altri studi dimostrano come nella diagnosi la macchina superi le competenze medie di un medico. Lo stesso si può dire per l’analisi di immagini radiografiche, di anatomia patologica ecc. L’impatto del deep learning abbraccia tutti i settori della conoscenza, dalle self-driving car che riconoscono gli oggetti della scena, al manufacturing per l’analisi dei difetti, alla robotica come ausilio alla navigazione, alla video sorveglianza, all’agricoltura di precisione. Siamo arrivati a dedurre informazioni tridimensionali da immagini acquisite con webcam. In futuro, sarà possibile provarsi virtualmente un vestito con lo smartphone prima di fare un acquisto. L’estrazione di informazioni in 3D di postura dalle immagini di una webcam è già realtà e presto sarà possibile riconoscere comportamenti umani per la riabilitazione. Le potenzialità di queste tecniche sono enormi, soprattutto nel campo della sanità e della sicurezza pubblica, dove però la protezione dei dati personali e la privacy pongono oggi delle barriere enormi nel reperire i dati, penalizzando soprattutto lo sviluppo di nuovi modelli di business basati sui servizi ad alto valore aggiunto. Il futuro della visione computazionale sarà orientato all’apprendimento auto-supervisionato e non ci sarà bisogno di annotare grandi mole di immagini ma, come avviene nei primi anni di vita, basterà interagire con il mondo esterno.

PRISMA: pubblicazione mensile registrata presso il Tribunale di Milano (N. 235 del 19.09.2018).

Tutti i diritti di proprietà artistica e letteraria sono riservati.

L’editore è a disposizione di eventuali detentori di diritti che non sia stato possibile rintracciare.

Mateinitaly srl – p.iva 09164520968 – Corso Vercelli 27 – 20144 Milano (MI).